Wyobraź sobie, że widzisz wideo, na którym jest osoba wyglądająca dokładnie jak Ty. Ma Twój głos, identyczną mimikę, ale mówi i robi rzeczy, z którymi się nie zgadzasz. Nieciekawy scenariusz? Jednak całkowicie możliwy. Deep fake, czyli fałszywe materiały tworzone przy wykorzystaniu sztucznej inteligencji na podstawie zdjęć ludzkich twarzy, funkcjonują w Internecie, a rozwój technologii sprawia, że odróżnienie oryginału od kopii jest niezwykle trudne. Co na to naukowcy?

Choć pojęcie deep fake po raz pierwszy pojawiło się zaledwie kilka lat temu, to przez ten czas technologia ta zdążyła się już błyskawicznie rozwinąć. Dynamiczny rozwój, a także ogromny wpływ na bezpieczeństwo, przemysł i wiele innych obszarów życia sprawiły, że temat podmiany twarzy stał się przedmiotem pracy naukowców z Wojskowej Akademii Technicznej. Czy deep fake’ów rzeczywiście należy się wyłącznie bać? A może mają też jasną stronę?

Najlepsze techniki podmiany twarzy

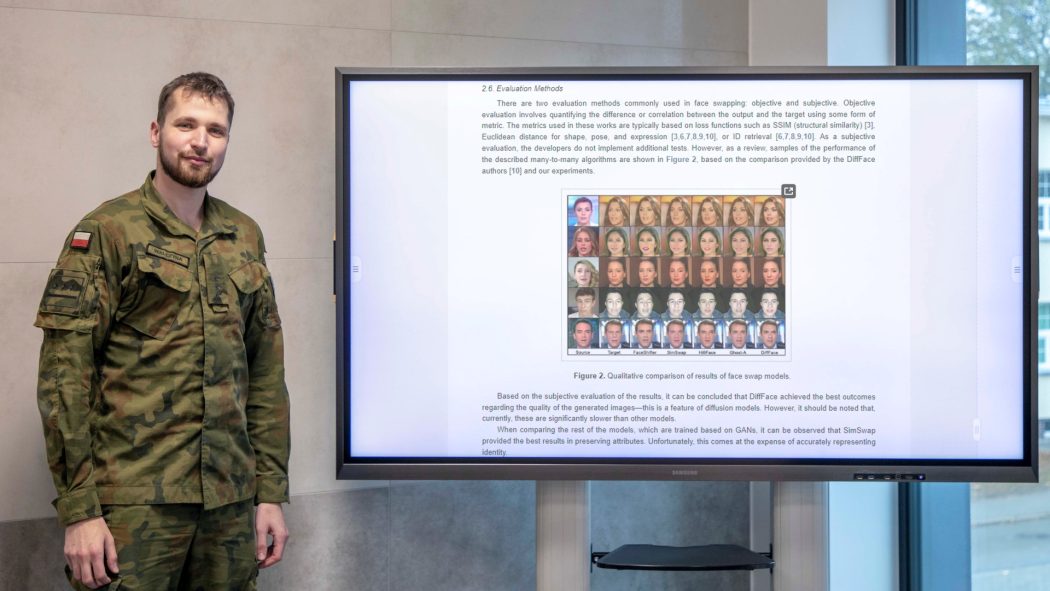

Głównym celem naukowców z WAT było rzetelne przeanalizowanie możliwości i ograniczeń technologii deep fake. Dr hab. inż. Zbigniew Piotrowski, prof. WAT oraz por. mgr inż. Tomasz Walczyna z Wydziału Elektroniki Wojskowej Akademii Technicznej efekty swoich badań przedstawili w artykule „Quick Overview of Face Swap Deep Fakes”, który ukazał się w czasopiśmie „Applied Sciences”. Wypracowane przez nich wyniki stanowią wartościowe źródło wiedzy o technikach podmiany twarzy, a w dalszej perspektywie mogą nawet pomóc w opracowaniu autorskiego algorytmu zmiany tożsamości, który będzie można wykorzystać m.in. w medycynie czy wojsku.

Naukowcy dokonali kompleksowego przeglądu i analizy nowoczesnych metod face swapping, czyli zamiany twarzy. Omówili i porównali obecnie wykorzystywane sposoby, takie jak m.in. generatywne sieci przeciwstawne (GAN, ang. generative adversarial networks), autoenkodery (AEs, ang. autoencoders) i modele dyfuzyjne (ang. diffusion models).

„Sieci GAN opierają się na treningu dwóch sieci neuronowych jednocześnie. Pierwsza, generator, próbuje stworzyć próbkę danych w taki sposób, aby ta druga, dyskryminator, odpowiedzialna za predykcję, czy próbka jest prawdziwa czy fałszywa, nie była w stanie zidentyfikować poprawnie generacji – i odwrotnie. Z kolei autoenkodery to sieci, które kompresują dane, aby następnie na ich podstawie spróbować zrekonstruować próbkę wejściową. W tym przypadku wykorzystuje się najczęściej kilka modeli przypisanych do poszczególnych osób. Modele dyfuzji natomiast w świecie generacji wraz z postępem technologicznym zyskały popularność stosunkowo niedawno. Wykorzystują one jedną strukturę modelu, jednak jest ona uruchamiana na próbce wiele razy z niewielkimi zmianami w parametrach wejściowych, co wydłuża proces generacji i treningu. Każda z tych metod to zarówno możliwości, jak i ograniczenia. Sukcesem byłoby połączenie mocnych stron w sprawnie działającą całość” – mówi por. mgr inż. Walczyna.

Naukowcy skupili się przede wszystkim na strategiach typu many-to-many, które są uniwersalne i umożliwiają zamianę twarzy w obrazie lub wideo na podstawie wyłącznie jednego zdjęcia. Dzięki temu pokazali, jak różne podejścia wpływają na jakość i szybkość generowania obrazów. „Tak rozbudowana analiza pozwoliła nam wyciągnąć ciekawe wnioski. Na przykład model DiffFace oparty na diffusion models generuje obrazy o najwyższej jakości, choć jest znacznie wolniejszy od innych modeli. Z kolei model SIM swap, oparty na GAN, doskonale zachowuje atrybuty, ale ma problem z dokładnym odwzorowaniem tożsamości” – tłumaczy por. mgr inż. Tomasz Walczyna.

Główne problemy, które autorzy postawili przed sobą, dotyczyły zrozumienia efektywności, precyzji i ograniczeń badanych technik. Istotnym wyzwaniem było rozpoznanie, jak poszczególne metody radzą sobie z rozmaitymi danymi. Twarze ludzi i ich ujęcia są przecież niezwykle różnorodne, a każdy rodzaj face swapping musi uwzględniać tę zmienność, aby zapewnić wysoką jakość wyników. „Staraliśmy się zidentyfikować, które techniki najskuteczniej zapewniają te cechy, a także zrozumieć, jak mogą być rozwijane i ulepszane. Chcieliśmy, aby badane metody i tym samym w przyszłości autorski algorytm charakteryzowała jak największa uniwersalność zastosowania” – podkreśla por. mgr inż. Walczyna.

Dzięki temu, że celem badaczy było nie tylko zrozumienie technologii face swapping, lecz także zidentyfikowanie silnych i słabych stron różnych metod podmiany twarzy, możliwe stało się wyróżnienie potencjalnych rozwiązań i wyznaczenie kierunku dla przyszłych badań.

Poznać zagrożenia…

Niezwykle istotną kwestię w opinii badaczy stanowią także zagrożenia, jakie technologia deep fake stwarza choćby w zakresie bezpieczeństwa – zarówno jednostek, jak i społeczeństwa.

Technologia face swapping może na przykład umożliwić tworzenie filmów z fałszywymi oświadczeniami wysokich rangą polityków lub dowódców wojskowych. Nietrudno sobie wyobrazić, że wykorzystanie takich materiałów mogłoby prowadzić do nieprzewidywalnych skutków na arenie międzynarodowej. Takie działania mogą prowokować konflikty czy spowodować destabilizację sytuacji politycznej poszczególnych krajów.

Innym zagrożeniem, które deep fake stwarza w zakresie bezpieczeństwa, jest potencjalne wykorzystanie podmiany twarzy w systemach bezpieczeństwa bazujących na biometrii. Rozwiązań biometrycznych jest na rynku coraz więcej, dlatego potencjalne szkody oznaczałyby poważne konsekwencje. Technologia face swapping mogłaby być wykorzystana do uzyskania nieautoryzowanego dostępu, ponieważ możliwe jest stworzenie realistycznej maski twarzy opartej na zdjęciach, a następnie używanie jej do podszywania się pod daną osobę do autoryzacji. To otwiera także nowy wymiar cyberataków, które służby bezpieczeństwa muszą wziąć pod uwagę.

Praca naukowców przyczynia się do zrozumienia tych zagrożeń, dostarczając wglądu w działanie technologii. Lepsze zrozumienie pozwoli skuteczniej zabezpieczyć się przed potencjalnymi zagrożeniami, a także rozważyć potencjalne zastosowania ofensywne.

…i wykorzystać możliwości

Naukowcy z WAT wskazali jednak także korzystne potencjalne zastosowania technologii zamiany twarzy w różnych sektorach, m.in. w medycynie, przemyśle rozrywkowym, edukacji czy wojsku.

W sektorze medycznym technologia deep fake dzięki umiejętnemu wykorzystaniu obrazów na przykład w terapii w kontrolowanym środowisku może pozytywnie wpłynąć na stan pacjentów. Deep fake można wykorzystać do stworzenia wirtualnych rekonstrukcji sytuacji, które były traumatyczne dla pacjenta. Może to być przydatne w terapii ekspozycyjnej, gdzie pacjent jest stopniowo narażany na sytuacje, które wywołują u niego lęk, ale w kontrolowanym środowisku. Technologia deep fake pozwoli na dokładne odwzorowanie sytuacji w taki sposób, żeby pacjent czuł się bezpiecznie. Dla przykładu – w przypadku osoby z traumą doznaną w wyniku wypadku samochodowego za pomocą deep fake można stworzyć realistyczną symulację tej sytuacji, w której pacjent mógłby się ponownie znaleźć, ale w bezpiecznych warunkach.

Deep fake świetnie sprawdzi się również w chirurgii plastycznej czy rekonstrukcyjnej. Umożliwi pacjentom zobaczenie przewidywanego efektu operacji i świadome podjęcie decyzji.

Z kolei w przypadku pacjentów z zaburzeniami neurologicznymi deep fake może wspierać komunikację, choćby dzięki wideo, które pomaga zrozumieć mowę. Niektóre osoby z zaburzeniami neurologicznymi mogą mieć trudności z rozumieniem mowy lub jej artykulacją. W takim przypadku technologia deep fake może być używana do tworzenia wideo z ludźmi, których pacjent zna, np. z członkami rodziny, którzy mówią w sposób zrozumiały dla pacjenta. Może to również obejmować wideo z mową „przetłumaczoną” na język, który pacjent rozumie lepiej.

Jeszcze innym obszarem jest edukacja medyczna. Tutaj realistyczne filmy stworzone z użyciem technologii pomogą pacjentom zrozumieć skomplikowane procedury lub metody leczenia, m.in. dzięki materiałom wykorzystującym wygląd i głos osoby, której pacjent ufa.

Technologia face swapping sprawdzi się również w sektorze rozrywkowym. Może tam zrewolucjonizować sposób tworzenia postaci w grach i filmach, ponieważ umożliwia tworzenie niezliczonych unikalnych twarzy.

Skorzysta także branża reklamowa – dzięki wykorzystaniu deep fake będzie mogła tworzyć jeszcze lepiej spersonalizowane kampanie, które dosłownie będą mówiły do klienta. Bez wątpienia to tylko początek, bo kreatywnych pomysłów na zastosowanie nowych technologii na pewno w tym obszarze nie zabraknie.

W sektorze usług techniki face swapping przyczynią się do stworzenia interfejsów naśladujących ludzkie emocje i wyraz twarzy. To znacznie ułatwi klientom korzystanie z nowoczesnych rozwiązań. Obniży też koszty, pozwoli zaoszczędzić czas i skuteczniej odpowie na potrzeby rynku.

W edukacji technologia deep fake oznacza innowacyjne metody nauczania i bardziej angażujące interakcje. Szkoła, w której podczas lekcji będzie można przywrócić do życia historyczne postaci i poznać wirtualne wersje Juliusza Cezara czy Marii Skłodowskiej-Curie, to marzenie niejednego ucznia. Deep fake to także większa skuteczność nauki języków obcych – wystarczy stworzyć symulację native speakerów, a uczestnicy kursu przećwiczą nowe idiomy i poprawią zdolność rozumienia rozmaitych akcentów. Nauczyciele z kolei dzięki deep fake zyskają niezawodny sposób na tworzenie w pełni spersonalizowanych materiałów edukacyjnych dostosowanych do potrzeb i preferencji ucznia. Na zajęciach teatralnych czy literackich deep fake może służyć do wizualizacji scen czy postaci i tym samym pomóc uczniom w lepszym zrozumieniu kontekstu.

W wojskowości technologia deep fake także przynosi nowe możliwości. Do szans zaliczyć można choćby wykorzystanie jej do doskonalenia treningów i symulacji dla żołnierzy, dzięki tworzeniu realistycznych scenariuszy bojowych. Pozwoli także znaleźć się w środku sytuacji kryzysowych, ale bez narażania ludzi na realne niebezpieczeństwa. Oczywiście może być też używana w działaniach psychologicznych, manipulacjach wizerunkiem czy rozpowszechniania dezinformacji, co może wpłynąć na działania wywiadowcze czy wojskowe przeciwnika.

W społeczeństwie technologia ta ma potencjał zmiany sposobu komunikacji i wyrażania siebie – może pozwolić ludziom na eksperymentowanie z różnymi tożsamościami w środowisku cyfrowym.

Ograniczenia deep fake

Praca z WAT podejmuje także temat wyzwań stojących przed technologiami zamiany twarzy. „Rozważamy problemy takie jak brak wystarczających danych do trenowania, złożoność twarzy ludzkich czy trudności związane z unikaniem artefaktów, które mogą zdradzić sztuczny charakter generowanych obrazów. Artefakty w kontekście technologii deep fake to niechciane lub nienaturalne efekty, które pojawiają się na wygenerowanych obrazach lub wideo. Mogą one manifestować się jako nieprawidłowości, błędy, deformacje czy niespójności w obrazie. Obecne algorytmy wymagają w procesie treningu dużych zbiorów danych, których dostępność może być ograniczona. Ponadto sieci neuronowe w pewnym procesie generalizują zagadnienie, a więc w przypadku generacji twarzy z widocznymi nienaturalnymi artefaktami może mieć ona problemy, by je odpowiednio zachować. Rozwój technologii zamiany twarzy musi iść w parze z ewolucją technologii wykrywania deep fake’ów, co stanowi dodatkowe wyzwanie dla twórców tych systemów” – tłumaczy por. mgr inż. Walczyna.

Naukowcy z Wojskowej Akademii Technicznej zwrócili uwagę na przyszłe kierunki badań i wskazali obszary, które zasługują na dalszą analizę, takie jak wymagania dotyczące wydajności w czasie rzeczywistym, skomplikowana indywidualna natura tożsamości ludzkiej, adaptacja algorytmów do różnych jakości danych czy opracowanie miar oceny jakości.

„Jeśli chodzi o wymagania dotyczące wydajności w czasie rzeczywistym, w erze cyfrowej, w której wiele operacji i decyzji podejmowanych jest w ułamkach sekund, technologie takie jak deep fake muszą działać szybko i sprawnie. Zwłaszcza w sytuacjach kryzysowych lub tam, gdzie dokładność i szybkość są kluczowe, a opóźnienia czy błędy w działaniu mogą prowadzić do niepożądanych skutków. Z kolei indywidualna natura tożsamości ludzkiej to aspekt, który jest fundamentalny dla deep fake, ale także bardzo skomplikowany. Ludzie różnią się między sobą nie tylko wyglądem, ale także mimiką czy gestami. Jeśli technologia ma prawidłowo naśladować czy identyfikować ludzi, musi być w stanie zrozumieć i odwzorować te subtelne różnice. Jeśli chodzi o adaptację algorytmów do różnych jakości danych, jest to ważne, ponieważ dane, na których opiera się deep fake, mogą być różnorodne. Mogą pochodzić z różnych źródeł, być różnej jakości czy rozdzielczości. Algorytmy muszą być na tyle elastyczne, aby radzić sobie z tą różnorodnością i wciąż działać skutecznie. Wreszcie opracowanie miar oceny jakości jest kluczowe, ponieważ pozwala ocenić, jak dobrze technologia działa i w jakim stopniu jest wiarygodna. Dla technologii, która ma na celu tworzenie budzących zaufanie imitacji, określenie, co sprawia, że imitacja może być zdefiniowana jako dobra lub przekonująca, jest kluczowe” – podsumowuje por. mgr inż. Tomasz Walczyna.

W przypadku deep fake istotne są jednak nie tylko kwestie techniczne, ale i etyczne. Badacze w swojej pracy zwracają uwagę na konieczność promowania odpowiedzialnego korzystania z technologii zamiany twarzy. Technologii, która – jak podkreślają autorzy z WAT – jest obszarem pełnym nie tylko wyzwań, lecz także niezwykle obiecujących możliwości.

Dominika Naruszko

fot. Marcin Wrzos